系统级玩家微软、苹果先后出牌,端侧大模型路径清晰了?

系统级玩家微软、苹果先后出牌,端侧大模型路径清晰了?

文 | 坚白鸣

落地端侧被认为是大模型走向普及的关键。个人 PC 和智能手机是当前受众最为广泛的两大终端品类。2023 年下半年以来,全球范围内各大 PC、手机厂商纷纷通过硬件扩容,尝试将大模型在物理意义上融入终端。

直到近期,大模型融入终端真正迎来关键节点。5 月,微软发布 Copilot + PC, 紧接着 6 月,苹果发布 Apple Intelligence。

系统级玩家着眼于全局的重塑,相比硬件玩家接近单点出击式的改造,显然不可同日而语。大模型落地终端或将迎来新的范式。但大方向趋同之下,微软与苹果在路径上的差异,也预示着演化路径仍将分叉而行。

而与此同时,技术演进正在逐步消解端侧部署大模型的必要性,这又为路径演化注入了更大的不确定性。

巨头的分歧:打造杀手级应用 VS 融入已有应用

5 月 21 日,微软发布 Copilot + PC, 重新定义 AI PC;而 6 月 11 日,苹果发布 Apple Intelligence,则试图重新定义 AI。发布会上,两大系统级玩家分别展示了一系列 AI 加持之下的新功能、新产品。虽然同样都是聚焦 AI,但各自在产品设计、议程设置上不同的着力点,清晰地体现着两者对于端侧 AI 落地路径有着截然不同的设想。

微软仍在追求杀手级应用。它全新发布的植根于 Windows 11 操作系统的 "Recall" 功能,仿佛能让时光倒流。借助于 PC 本地端大模型的加持,电脑能够 " 记住 " 此前进行过的所有操作,然后在用户需要时,简单一句话即可立即召回。

尽管这并不是一种全新的产品概念——类似的回溯功能早已存在,但这确实是一种基于硬件升级的全新尝试。"Recall" 功能的的原理是在电脑运行期间,每隔几秒钟捕捉一次屏幕快照,并持续堆积至电脑硬盘,以备用户在以后某个时间根据模糊的记忆找到它们。由于有 PC 本地端大模型的加持,召回的过程超越了常规精准检索,从而更加便捷高效。

一系列操作的实现,都建立在更为强大的硬件性能基础上上。微软为 Copilot + PC 设置了硬件门槛,在传统的 CPU、GPU 之外,还需要配置 NPU,且 AI 算力需要超过 40 TOPS,同时内存要达到 16G、固态硬盘达到 256GB。无论是算力还是内存,都远超市面上绝大多数已有 PC 产品。

抢先接入 OpenAI GPT-4o,让同样根植于 Windows 11 操作系统的 Copilot 具备令人惊艳的 " 读屏 " 能力,是微软打造杀手级应用的另一种尝试,尽管这并不属于端侧原生功能。根据现场演示,新款 PC 中的 Copilot 能够 " 看懂 " 屏幕上正在显示的游戏画面,并可基于自身理解实时提供操作建议,这相当于在电脑中内置了一个永远不厌其烦的游戏专家,而且所能提供的建议是开放式的,远远超出了只有固定剧本的 NPC(非玩家控制角色)概念。

与微软形成鲜明对比,苹果则显然没有打造杀手级应用的执念。Apple Intelligence 是苹果的 AI 首秀,它为准备首秀花费的时间最长,但它发布的产品却最为平淡。

Apple Intelligence 所提供的一系列功能,比如文本修改校对、归纳总结、图片生成等等,不仅并未超出其它大模型的能力范畴,而且相比安卓友商们已经实现的功能,也并无出彩之处。与微软 Copilot 一样,新版 Siri 同样接入了 GPT-4o,但在 Apple Intelligence 的体系中,GPT-4o 的地位相当边缘化,仅在遇到复杂问题时,Siri 才会经用户同意调用 GPT-4o。让功能强悍的 GPT-4o 扮演可有可无的外挂角色,清晰地表明,苹果并不打算像微软那样倚重 OpenAI 以打造更具冲击力的功能。

苹果也没有像微软那样将硬件门槛陡然拔高。苹果为 Apple Intelligence 设定的硬件门槛是 A17 Pro(手机端)以及 M 系列芯片(平板和电脑端)。A17 Pro 的 AI 算力为 35 TOPS,内存为 8 GB,目前仅有 iPhone 15 Pro 和 15 Pro Max 两款手机配备 A17 Pro。M 系列芯片以下限 M1 为例,AI 算力约为 11TOPS,内存为 8GB,近几年发布的 iPad 及 Mac 电脑普遍都达标。结合 iPhone 15 配备 A16 芯片 AI 算力、内存分别为 17TOPS、6GB,但不能支持 Apple Intelligence,有分析认为苹果为端侧 AI 设置的门槛,其实仅仅是内存 8GB。

在苹果看来,炫技式的单点功能突破以及硬件性能的堆叠,都不是端侧 AI 的核心。苹果更愿意强调的,是基于现有的硬件条件,将 AI 融入已有的应用形态。它为此构建了一个略显复杂的三层大模型架构,分别是本地端 30 亿参数级的小模型、未公布参数量的云端大模型,以及外挂大模型 GPT-4o。

虽然据发布会后苹果官方技术博客披露,苹果自研大模型性能相当出色—— 30 亿参数级小模型相比主流几个 70 亿级模型能力上基本都能胜出、云端模型性能能够达到 GPT-4 Turbo 级别,但在苹果看来,这些单纯的大模型能力,同样不足以成为发布会的核心看点之一。苹果 CEO 蒂姆 · 库克(Tim Cook)在发布会上提出了 Apple Intelligence 的五大开发原则,其中第三条是 " 整合 "(Integrated),意思是 AI 必须集成到产品体验中。

系统级玩家的共识:构建 AI 基础设施

苹果的 " 整合 " 不仅仅停留在自有 App,还面向所有第三方 App。苹果专门设计了一套全新的框架,并公布了第一批配套的开发工具,包括 App Intents API、Image Playground API 等,未来第三方开发者可以直接调用 Apple Intelligence,将 AI 功能融入自己的 App。

事实上,这同样是微软的选择。微软为其 Copilot + PC 设置了一个两层的大模型架构,其中本地端与苹果不同,微软选择了多模型方案,Copilot + PC 内置的大模型数量多达 40 个,而云端则直接接入 GPT-4o。与发布 Copilot + PC 同步,微软推出了 "Windows Copilot Runtime" 工具套件,支持开发者利用 Windows 内建的这 40 多个 AI 模型,催生全新的应用程序体验。

这或许是两大系统级玩家关于大模型落地端侧最为重要的共识之一。微软是全球最大的 PC 操作系统厂商,市占率高达 70%;苹果横跨 PC、手机端,软硬一体,是全球最大的闭源操作系统厂商,全球 80 亿人里,有超过 10 亿人使用 iPhone,还有数亿人使用苹果的个人电脑、耳机、手表。

在操作系统层面提供 AI 基础设施,或许才是更为长远也更为务实的考量。距离 2022 年 11 月 ChatGPT 震撼出世,已经将近 20 个月,各大科技公司的天量资源投入仍在继续,但大模型的进化速度呈现放缓迹象。以点燃这波生成式 AI 热潮的大模型文本处理能力为例,OpenAI 在 5 月 13 日推出了最新模型 GPT-4o,据官方公布的评测数据,相比此前的 GPT-4 Turbo,GPT-4o 文本处理能力提升不大,MMLU(本科生水平的知识)得分提升 2.5%,HumanEval(编程能力)提升 3.6%,MGSM(跨语言数学能力)提升 2.3%,而 DROP(文本段落分析推理)则下降了 3%。

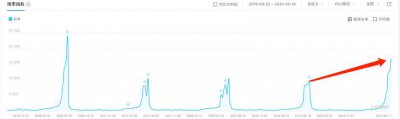

但与此同时,杀手级应用仍未出现。根据第三方网站 SimilarWeb 的监测数据,早在去年 6 月,ChatGPT 流量即已见顶,当月其网站与移动客户端的全球流量(PV)环比下降 9.7%,独立访客数量(UV)下降了 5.7%,访客在网站上花费的时间也下降了 8.5%。而国内轰轰烈烈的 " 百模大战 " 之后,大模型玩家们已推出数十款 AI 产品,但表现最好的头部大模型 APP 日活跃量也仅在百万级别。

在云端大模型尚不足以催生杀手级应用的局面下,要想在受限于硬件短板的端侧构建基于本地大模型能力的杀手级应用,显然更为困难。相比之下,在操作系统层面提供 AI 基础设施,对于真正推动大模型在端侧落地,或许是更为务实的选择。这不仅能够更有成效地推动大模型技术与现有应用融合,而且也可以建立系统级的 AI 生态,让杀手级应用自然而然地生长出来。

技术演进动摇端侧大模型的必要性

但从技术演进来看,大模型落地端侧本地的驱动力开始衰减。

一直以来,成本考量及隐私保护,是推动大模型从云端落地终端的两大因素。

云端大模型普遍千亿级的参数,意味着高昂的推理成本。将推理环节下放至终端,则相当于让终端用户平摊成本,其中包括服务器成本和电力成本。

但 5 月份以来,经过一轮激烈的价格战,大模型调用价格已经大幅下降,甚至部分被打至白菜价。OpenAI 新模型 GPT-4o 的 API 价格降至上一版本 GPT-4 Turbo 的一半,处理 100 万 Token 的输入仅需 5 美元,谷歌同样将其主力模型 Gemini 1.5 Pro 的调用价格打 5 折,处理 100 万 Token 的费用降至 3.5 美元。

而国内模型的降价幅度更为夸张。字节豆包大模型将处理输入文本的价格定在 0.8 元 / 百万 Tokens,阿里则把对标 GPT-4 的 Qwen-Long API 输入价格降到 0.5 元 / 百万 Tokens,百度更是宣布主力模型文心一言 ERNIE Speed 和 Lite 模型免费使用。

大幅降价背后,除了短期的市场竞争因素之外,技术演进是支撑降价的趋势性力量。在硬件层面,大模型算力的硬通货英伟达 GPU 的性价比在快速提升。英伟达年初宣称,靠着改进推理框架等方法,一年时就把大模型推理成本减少到了原本的四分之一。今年 3 月,英伟达发布新产品 GB200 ,宣称它能把大模型推理性能再提高 30 倍。在训练及推理层面,技术的优化也带来降本。比如字节在宣布大模型降价时透露,通过调整模型架构、把在单个设备上做推理改成在多个设备上分布式推理,集中处理模型调用任务,可以提升芯片的利用率,从而将成本降低。

伴随大模型推理成本的持续下降,从成本出发要求大模型落地端侧的必要性也将随之减弱。此外,从隐私保护、数据安全出发的必要性,似乎也开始动摇。

对于如何在调用云端大模型的过程中保障用户的数据安全,一向注重用户隐私的苹果,提出了新的解决方案——私有云计算。私有云计算位于 Apple Intelligence 三层大模型架构中的第二层,介于本地端大模型以及外挂大模型之间,发挥承上启下作用。按照苹果的解释,私密云计算更像是一个加密协议,具体而言,Apple Intelligence 在处理 AI 相关任务时,首先会评估任务是否能够由本地端大模型完成,如果不能,Apple Intelligence 则会通过加密的方式打包一个请求,其中包含与任务相关的提示信息以及需要动用的云端模型,与之相应的是,只有要使用的特定 AI 模型才会拥有正确的密钥。而且这些私密性数据 " 阅后即焚 ", 任何传输到云端的个人数据将仅用于手头的人工智能任务,在模型完成请求后,苹果不会保留或访问这些数据,即使是用于调试或质量控制。

苹果的方案是否行之有效并成为一种新的范式,还有待时间检验。但可以肯定的是,微软苹果等端侧系统级玩家的入场,将为大模型的端侧生态带来巨大影响,叠加技术演进开始动摇大模型落地本地端的必要性,端侧 AI 的实现路径或将迎来重大切换。

-

- 众高管热议“新能源车人才缺口103万”,到底缺什么人才?

-

2024-06-23 01:41:55

-

- 2024 WAIC「全球创新项目路演」征集!最高可获千万算力补贴

-

2024-06-23 01:39:39

-

- 618没有原罪,白牌才是消费压舱石

-

2024-06-23 01:37:22

-

- 抖音电商618破防

-

2024-06-23 01:35:07

-

- 一场遇见爱情的旅行1~52集全集剧情介绍 一场遇见爱情的旅行第4~5集预告

-

2024-06-23 01:32:50

-

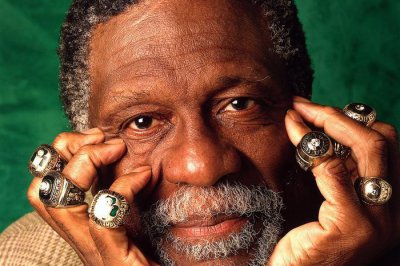

- “指环王”去世:他改变了NBA,未能目睹种族歧视现状改变

-

2024-06-23 01:30:34

-

- 梁博你好好唱歌,别尬聊了

-

2024-06-23 01:28:18

-

- 53岁刘若英,模样大变

-

2024-06-23 01:26:02

-

- 分布式数据库时代,需要什么样的产品?

-

2024-06-22 09:26:26

-

- 为回国执教放弃高薪,培养出王濛、武大靖的"教母李琰"究竟有多强

-

2024-06-22 09:24:10

-

- 皇太子在乱世中活了下来,他一路乞讨,成功回到了京城

-

2024-06-22 09:21:54

-

- 残疾人证=残疾人身份证,14个秘密给你解答

-

2024-06-22 09:19:38

-

- 爱无尽,情更深——回忆父亲吴印咸

-

2024-06-22 09:17:22

-

- 向华强家族聚会,手握价值46万国产手机的新义安龙头何许人也?

-

2024-06-22 09:15:06

-

- 那些年非常火的英文歌,70、80、90后共同的记忆!

-

2024-06-22 09:12:50

-

- 贾马尔-穆雷,一位走在伟大道路上的超级二当家

-

2024-06-22 09:10:34

-

- 3小时入账2亿,张雪峰们都在赚谁的钱?

-

2024-06-22 09:08:18

-

- 白脱、哈斗、别司忌都是啥?只有上海人才晓得!

-

2024-06-22 09:06:03

-

- 首届金马奖影后尤敏:美过林青霞,28岁息影嫁人,被亲妈告上法庭

-

2024-06-20 12:53:35

-

- 详解《龙珠》超级反派:宇宙帝王弗利萨,超强原画手稿合集

-

2024-06-20 12:51:18

世界综合国力排名(联合国五常综合实力大排名)

世界综合国力排名(联合国五常综合实力大排名) 2023年十大高产玉米品种(排名第一的玉米品种名字)

2023年十大高产玉米品种(排名第一的玉米品种名字)